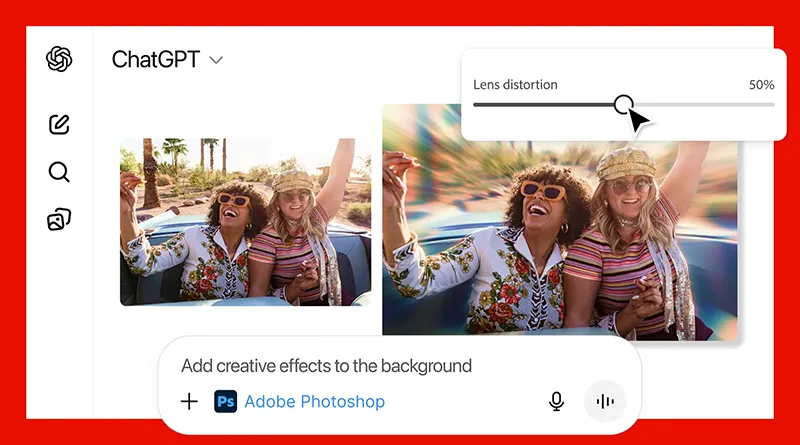

Adobe интегрира Photoshop, Express и Acrobat директно в ChatGPT

Adobe обяви официалния старт на Photoshop, Adobe Express и Adobe Acrobat за ChatGPT, което прави водещите ѝ креативни и продуктивни инструменти достъпни за над 800 милиона потребители на платформата

Прочети публикацията